Conecta un modelo de lenguaje grande (LLM, por sus siglas en inglés) con NeuralSeek

Mejora tu experiencia en NeuralSeek siguiendo estas instrucciones para agregar al menos un LLM (Modelo de Lenguaje Grande) y optimizar sus funcionalidades. Si agregas más de uno, NeuralSeek los equilibrará para las funciones que pueden usar múltiples LLM. Si un LLM no puede manejar ciertas funciones, esas funciones no estarán disponibles. Si no se agrega un LLM para una función, esa parte de NeuralSeek no funcionará.

⚠ A fin de configurar un LLM, asegúrate de que te hayas suscrito al plan Bring Your Own LLM (BYOLLM). Todos los demás planes usarán el LLM curado por NeuralSeek, y esta opción no estará disponible. Recuerda que es responsabilidad de cada participante comprender y administrar los costos asociados con el uso de NeuralSeek y cualquier otro servicio integrado dentro de su entorno AWS.

Agrega un LLM

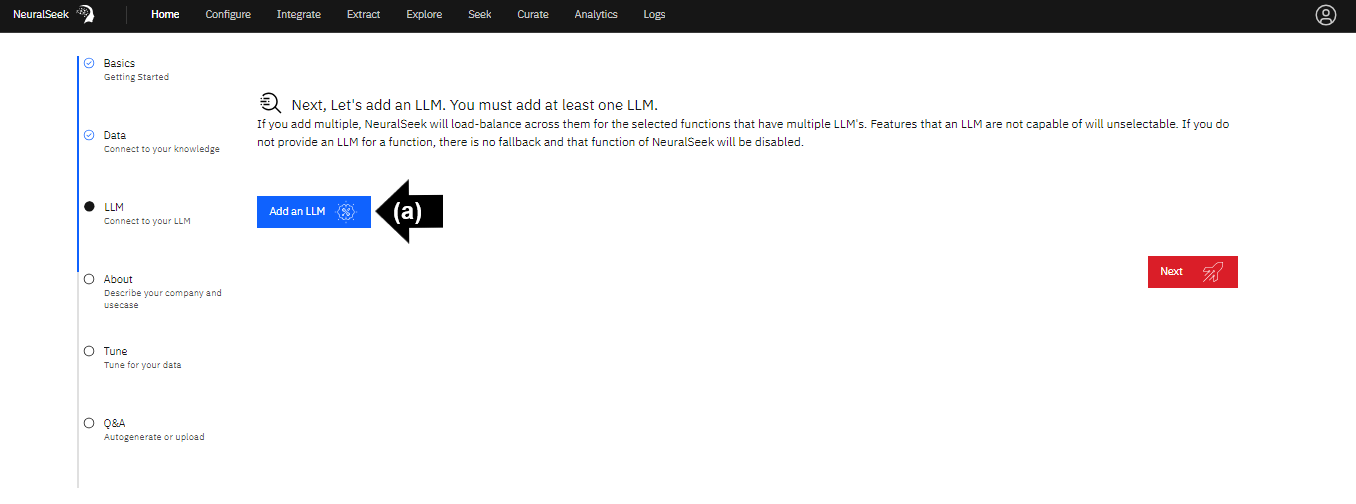

Ve a la interfaz de usuario de NeuralSeek.

En la pestaña "Inicio", sigue los pasos para conectarte a tu LLM.

⚠️ Debes agregar al menos un LLM.

- (a) Haz clic en "Agregar un LLM".

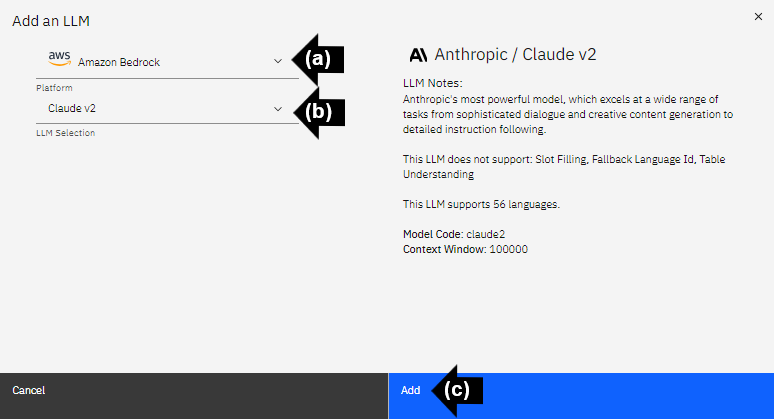

Plataforma y selección de LLM

Para los usuarios de AWS, se recomienda conectarse a la plataforma Amazon Bedrock, y seleccionar el LLM Claude v2.

- (a) Haz clic en el menú desplegable para seleccionar la plataforma LLM. Para este ejemplo, selecciona Amazon Bedrock.

- (b) Haz clic en el menú desplegable para seleccionar el LLM. Para este ejemplo, selecciona Claude v2.

- (c) Haz clic en "Agregar" para agregar el LLM.

Funciones de LLM

Las instrucciones para la generación y ubicación de la información de la "AWS Access Key" se pueden encontrar en la guía "Información adicional de AWS" del laboratorio.

- Ingresa la "Amazon Bedrock AWS Role Access Key".

- Ingresa la "Amazon Bedrock AWS Role Secret Access Key".

- Ingresa la "Amazon Bedrock AWS Region".

- Habilita los idiomas LLM disponibles. NeuralSeek habilitará por defecto los 56 idiomas disponibles.

- Selecciona las funciones LLM deseadas. NeuralSeek seleccionará por defecto todas las funciones disponibles. Para los fines de este laboratorio, selecciona las siguientes: Detección de información de identificación personal, Generación de conversación, Extracción de entidad, Categorización, Generación de ejemplo, Creación de intención, Traducir, Sentimiento alternativo y mAIstro.

Prueba el LLM

- Haz clic en "Probar" para probar el LLM.

Un gran modelo de lenguaje ahora está conectado a NeuralSeek.

⚠️ Los LLM pueden variar en sus capacidades y desempeños. Algunos LLM pueden tardar hasta 30 segundos y más en generar una respuesta completa. Ten cuidado al usarlo junto con una plataforma de agente virtual que imponga un tiempo de espera estricto.