Conecte um Modelo de Linguagem Grande (LLM) ao NeuralSeek

Aprimore sua experiência no NeuralSeek seguindo estas instruções para adicionar perfeitamente pelo menos um LLM (Modelo de Linguagem Grande) e otimizar suas funcionalidades. Se você adicionar mais de um, o NeuralSeek os equilibrará para funções que podem usar vários LLMs. Se um LLM não conseguir lidar com certos recursos, eles não estarão disponíveis. Se você não adicionar um LLM para uma função, essa parte do NeuralSeek não funcionará.

⚠️ Para configurar um LLM, certifique-se de que você se inscreveu no plano Bring Your Own LLM (BYOLLM). Todos os outros planos usarão o LLM selecionado pelo NeuralSeek e esta opção não estará disponível. Lembre-se, é responsabilidade de cada participante entender e gerenciar os custos associados ao uso do NeuralSeek e quaisquer outros serviços integrados em seu ambiente IBM Cloud.

Adicionar um LLM

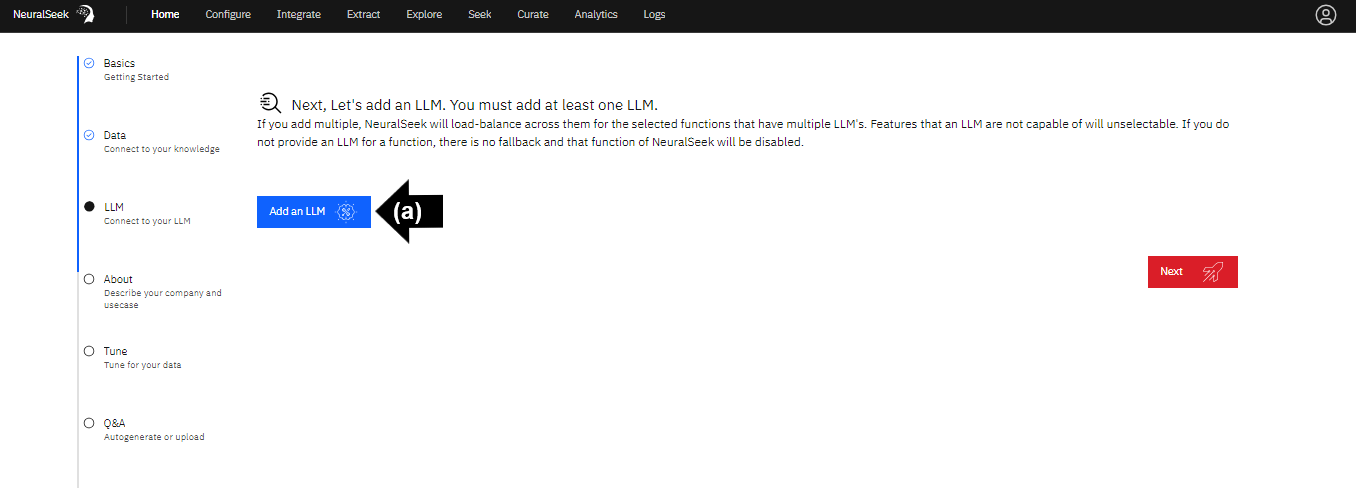

Navegue até a interface do usuário do NeuralSeek.

Na guia Home, siga as etapas para se conectar ao seu LLM.

⚠️ É necessário adicionar pelo menos um LLM.

- (a) Clique em Adicionar um LLM.

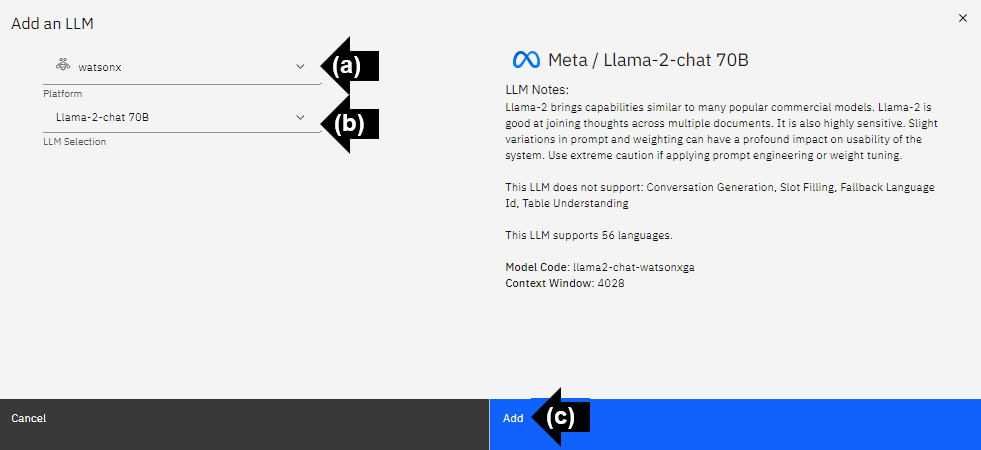

Seleção de Plataforma e LLM

Para usuários da IBM, é recomendado conectar-se à plataforma watsonx e selecionar o LLM Llama-2-chat 70B.

- (a) Clique no menu suspenso para selecionar a plataforma LLM. Para este exemplo, selecione watsonx.

- (b) Clique no menu suspenso para selecionar o LLM. Para este exemplo, selecione Llama-2-chat 70B.

- (c) Clique em Adicionar para adicionar o LLM.

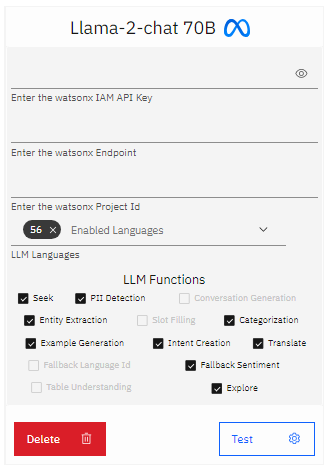

Funções LLM

As informações de chave IAM da API de watsonx, URL do ponto final e ID do projeto podem ser encontradas na sua conta IBM Cloud dentro da instância ativa encontrada na lista de recursos.

- Insira a chave IAM da API de watsonx.

- Insira a URL do ponto final de watsonx.

- Insira o ID do projeto de watsonx.

- Habilite os idiomas LLM disponíveis. O NeuralSeek habilitará por padrão todos os 56 idiomas disponíveis.

- Selecione as funções LLM desejadas. O NeuralSeek selecionará todas as funções disponíveis por padrão. Para o propósito deste laboratório, selecione os seguintes: Detecção PII, Geração de Conversação, Extração de Entidades, Categorização, Geração de Exemplos, Criação de Intenção, Traduzir, Sentimento de Falha e Explorar.

Teste do LLM

- Clique em Teste para testar o LLM.

Um grande modelo de linguagem agora está conectado ao NeuralSeek.

⚠️ A funcionalidade dos LLMs pode variar em sua capacidade e desempenho. Alguns LLMs podem levar até 30 segundos ou mais para gerar uma resposta completa. Use com cautela em conjunto com uma plataforma de agente virtual que impõe um intervalo rigoroso.